7 thuật toán học sâu phải biết

Lĩnh vực trí tuệ nhân tạo (AI) phát triển nhanh chóng trong thời gian gần đây, kéo theo sự phát triển của các thuật toán học sâu. Với sự ra mắt của các công cụ AI như DALL-E và OpenAI, học sâu đã nổi lên như một lĩnh vực nghiên cứu chính. Tuy nhiên, với vô số thuật toán có sẵn, có thể khó biết thuật toán nào là quan trọng nhất để hiểu.

Hòa mình vào thế giới hấp dẫn của deep learning và khám phá những thuật toán hàng đầu, cần phải biết, rất quan trọng để hiểu được trí tuệ nhân tạo.

Mục Lục

1. Mạng thần kinh tích chập (CNN)

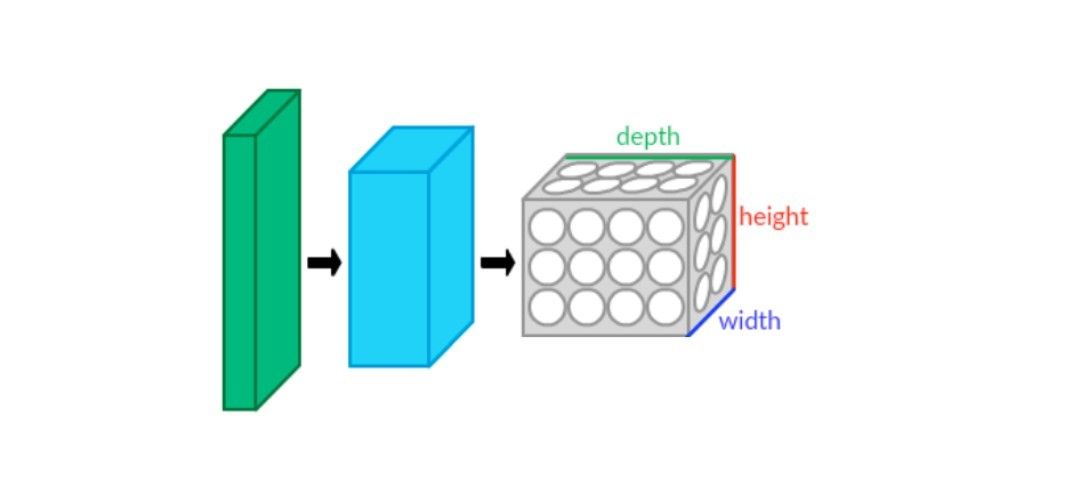

Mạng thần kinh chuyển đổi (CNN), còn được gọi là ConvNet, là mạng thần kinh vượt trội trong việc phát hiện đối tượng, nhận dạng hình ảnh và phân đoạn. Họ sử dụng nhiều lớp để trích xuất các tính năng từ dữ liệu có sẵn. CNN chủ yếu bao gồm bốn lớp:

- lớp tích chập

- Đơn vị tuyến tính chỉnh lưu (ReLU)

- Lớp tổng hợp

- Lớp kết nối đầy đủ

Bốn lớp này cung cấp một cơ chế hoạt động cho mạng. Lớp tích chập là lớp đầu tiên trong CNN, lớp này lọc ra các tính năng phức tạp khỏi dữ liệu. Sau đó, ReLU ánh xạ dữ liệu để huấn luyện mạng. Sau đó, quy trình sẽ gửi bản đồ tới lớp tổng hợp, giúp giảm việc lấy mẫu và chuyển đổi dữ liệu từ 2D thành một mảng tuyến tính. Cuối cùng, lớp được kết nối đầy đủ tạo thành một ma trận tuyến tính phẳng được sử dụng làm đầu vào để phát hiện hình ảnh hoặc các loại dữ liệu khác.

2. Mạng lưới niềm tin sâu sắc

Deep Belief Networks (DBN) là một kiến trúc phổ biến khác dành cho deep learning, cho phép mạng học các mẫu trong dữ liệu với các tính năng trí tuệ nhân tạo. Chúng lý tưởng cho các tác vụ như phần mềm nhận dạng khuôn mặt và phát hiện đặc điểm hình ảnh.

Cơ chế DBN liên quan đến các lớp khác nhau của Máy Boltzmann bị hạn chế (RBM), là một mạng thần kinh nhân tạo giúp học và nhận dạng các mẫu. Các lớp của DBN tuân theo cách tiếp cận từ trên xuống, cho phép giao tiếp trong toàn hệ thống và các lớp RBM cung cấp một cấu trúc mạnh mẽ có thể phân loại dữ liệu dựa trên các danh mục khác nhau.

3. Mạng thần kinh tái phát (RNN)

Mạng thần kinh tái phát (RNN) là một thuật toán học sâu phổ biến với nhiều ứng dụng. Mạng được biết đến nhiều nhất với khả năng xử lý dữ liệu tuần tự và các mô hình ngôn ngữ thiết kế. Nó có thể tìm hiểu các mẫu và dự đoán kết quả mà không cần đề cập đến chúng trong mã. Ví dụ: công cụ tìm kiếm Google sử dụng RNN để tự động hoàn thành các tìm kiếm bằng cách dự đoán các tìm kiếm có liên quan.

Mạng hoạt động với các lớp nút được kết nối với nhau giúp ghi nhớ và xử lý các chuỗi đầu vào. Sau đó, nó có thể hoạt động thông qua các trình tự đó để tự động dự đoán các kết quả có thể xảy ra. Ngoài ra, RNN có thể học hỏi từ các đầu vào trước đó, cho phép chúng phát triển với mức độ tiếp xúc nhiều hơn. Do đó, RNN là lý tưởng cho mô hình hóa ngôn ngữ và mô hình hóa tuần tự.

4. Mạng bộ nhớ dài hạn ngắn hạn (LSTM)

Mạng bộ nhớ ngắn hạn dài (LSTM) là loại Mạng thần kinh tái phát (RNN) khác với các loại khác ở khả năng làm việc với dữ liệu dài hạn. Chúng có bộ nhớ đặc biệt và khả năng dự đoán, làm cho LSTM trở nên lý tưởng cho các ứng dụng như dự đoán chuỗi thời gian, xử lý ngôn ngữ tự nhiên (NLP), nhận dạng giọng nói và sáng tác nhạc.

Mạng LSTM bao gồm các khối bộ nhớ được sắp xếp theo cấu trúc giống như chuỗi. Các khối này lưu trữ thông tin và dữ liệu liên quan có thể cung cấp thông tin cho mạng trong tương lai đồng thời loại bỏ mọi dữ liệu không cần thiết để duy trì hiệu quả.

Trong quá trình xử lý dữ liệu, LSTM thay đổi trạng thái ô. Đầu tiên, nó loại bỏ dữ liệu không liên quan thông qua lớp sigmoid. Sau đó, nó xử lý dữ liệu mới, đánh giá các phần cần thiết và thay thế dữ liệu không liên quan trước đó bằng dữ liệu mới. Cuối cùng, nó xác định đầu ra dựa trên trạng thái ô hiện tại đã lọc dữ liệu.

Khả năng xử lý dữ liệu dài hạn khiến LSTM khác biệt với các RNN khác, khiến chúng trở nên lý tưởng cho các ứng dụng yêu cầu các khả năng như vậy.

5. Mạng đối thủ sáng tạo

Mạng đối thủ chung (GAN) là một loại thuật toán học sâu hỗ trợ AI tổng quát. Chúng có khả năng học tập không giám sát và có thể tự tạo ra kết quả bằng cách đào tạo thông qua các bộ dữ liệu cụ thể để tạo các phiên bản dữ liệu mới.

Mô hình GAN bao gồm hai yếu tố chính: bộ tạo và bộ phân biệt. Trình tạo được đào tạo để tạo dữ liệu giả dựa trên quá trình học của nó. Ngược lại, bộ phân biệt đối xử được đào tạo để kiểm tra đầu ra xem có dữ liệu giả hoặc lỗi nào không và khắc phục mô hình dựa trên dữ liệu đó.

GAN được sử dụng rộng rãi để tạo hình ảnh, chẳng hạn như nâng cao chất lượng đồ họa trong trò chơi điện tử. Chúng cũng hữu ích để nâng cao hình ảnh thiên văn, mô phỏng thấu kính hấp dẫn và tạo video. GAN vẫn là một chủ đề nghiên cứu phổ biến trong cộng đồng AI, vì các ứng dụng tiềm năng của chúng rất rộng lớn và đa dạng.

6. Perceptron đa lớp

Multilayer Perceptron (MLP) là một thuật toán học sâu khác, cũng là một mạng thần kinh với các nút được kết nối với nhau trong nhiều lớp. MLP duy trì một chiều luồng dữ liệu duy nhất từ đầu vào đến đầu ra, được gọi là feedforward. Nó thường được sử dụng cho các nhiệm vụ phân loại đối tượng và hồi quy.

Cấu trúc của MLP bao gồm nhiều lớp đầu vào và đầu ra, cùng với một số lớp ẩn, để thực hiện các tác vụ lọc. Mỗi lớp chứa nhiều nơ-ron được kết nối với nhau, thậm chí giữa các lớp. Dữ liệu ban đầu được đưa đến lớp đầu vào, từ đó dữ liệu sẽ tiến triển qua mạng.

Các lớp ẩn đóng một vai trò quan trọng bằng cách kích hoạt các chức năng như ReLUs, sigmoid và tanh. Sau đó, nó xử lý dữ liệu và tạo đầu ra trên lớp đầu ra.

Mô hình đơn giản nhưng hiệu quả này rất hữu ích cho phần mềm dịch và nhận dạng giọng nói và video. MLP đã trở nên phổ biến do thiết kế đơn giản và dễ thực hiện trong các lĩnh vực khác nhau.

7. Bộ mã hóa tự động

Bộ mã hóa tự động là một loại thuật toán học sâu được sử dụng cho việc học không giám sát. Đó là mô hình chuyển tiếp với luồng dữ liệu một chiều, tương tự như MLP. Bộ mã hóa tự động được cung cấp đầu vào và sửa đổi nó để tạo đầu ra, có thể hữu ích cho việc dịch ngôn ngữ và xử lý hình ảnh.

Mô hình bao gồm ba thành phần: bộ mã hóa, mã và bộ giải mã. Họ mã hóa đầu vào, thay đổi kích thước của nó thành các đơn vị nhỏ hơn, sau đó giải mã nó để tạo ra một phiên bản sửa đổi. Thuật toán này có thể được áp dụng trong nhiều lĩnh vực khác nhau, chẳng hạn như thị giác máy tính, xử lý ngôn ngữ tự nhiên và hệ thống đề xuất.

Chọn thuật toán học sâu phù hợp

Để chọn phương pháp học sâu phù hợp, điều quan trọng là phải xem xét bản chất của dữ liệu, vấn đề hiện tại và kết quả mong muốn. Bằng cách hiểu các nguyên tắc và khả năng cơ bản của từng thuật toán, bạn có thể đưa ra quyết định sáng suốt.

Chọn thuật toán phù hợp có thể tạo ra tất cả sự khác biệt trong sự thành công của một dự án. Đây là một bước thiết yếu để xây dựng các mô hình học sâu hiệu quả.